AI som verktyg

Innan vi påbörjar vår kronologiska resa genom AI-historien tar vi ett praktiskt och nödvändigt kliv in i nutiden. Du som läser detta kommer med största sannolikhet att använda moderna AI-verktyg, som stora språkmodeller (LLM), både i dina studier och i ditt framtida arbetsliv. Därför är det avgörande att du redan nu får en robust verktygslåda för att hantera dessa kraftfulla system.

Detta kapitel är uppdelat i två delar. I den första delen lär du dig hantverket: hur du blir en skicklig och effektiv användare av AI som ett verktyg för att förstärka ditt eget tänkande. I den andra delen granskar vi bränslet som driver dessa system – data – och varför du måste vara djupt kritisk till hur det samlas in och används.

Del A: Hur du blir en skicklig användare

Kognitiv Augmentation: Mer än bara Automation

Det är lätt att se AI som ett verktyg för automation – något som gör jobbet åt dig. Du kan be den skriva en text, sammanfatta en artikel eller generera en bild, och den gör det. Men att bara se AI som en ersättare för arbete är att missa dess verkliga potential.

Ett mycket kraftfullare synsätt är att se AI som ett verktyg för kognitiv augmentation. Ordet augmentation betyder "förstärkning" eller "utökning". Tänk på AI som en "kognitiv partner". Målet är inte att låta AI:n tänka istället för dig, utan att använda den för att tänka bättre, snabbare och mer kreativt själv.

Exempel på kognitiv augmentation i praktiken:

- Idégenerering & Brainstorming: Använd AI som ett outtröttligt bollplank. Be den om tio galna idéer, be den kritisera din bästa idé, eller be den kombinera två dåliga idéer till en ny, spännande.

- Sammanfattning: Klistra in en lång, komplex text och be AI:n att korta ner den till ett fåtal huvudpunkter. Detta frigör din mentala energi till att analysera och kritisera texten, istället för att bara läsa den.

- Lärande & Förklaring: Be AI:n förklara ett svårt koncept (som kvantfysik eller ett filosofiskt argument) med några olika analogier tills du hittar en som klickar för dig.

- Strukturering & Omformulering: Klistra in dina röriga, ostrukturerade anteckningar och be AI:n att organisera dem under logiska rubriker eller att omformulera en klumpig mening så att den blir tydligare.

I alla dessa fall är det fortfarande du som styr, du som utvärderar och du som äger slutprodukten. AI:n är ett verktyg som förstärker din egen intelligens.

En modern pilot automatiserar stora delar av flygningen med en autopilot. Men piloten lämnar aldrig cockpit. Hen övervakar systemen, hanterar oväntade händelser och har alltid det slutgiltiga ansvaret. Se på AI på samma sätt: låt den vara din autopilot för kognitiva uppgifter, men behåll alltid själv kommandot.

Hantverket: Att Skriva Prompter som Fungerar

För att kunna använda AI som ett effektivt kognitivt verktyg måste du behärska hantverket att kommunicera med den. Detta kallas ofta prompt engineering eller prompthantverk. Din interaktion med en språkmodell är inte en konversation mellan jämlikar; det är en instruktion till ett verktyg. En vag och slarvig fråga leder till ett vagt och slarvigt svar. En precis, genomtänkt och kontextrik instruktion leder till ett användbart och relevant svar.

Istället för en rigid metod kan du tänka på en bra prompt som en uppsättning tydliga instruktioner. Ju bättre du specificerar vad du vill ha, desto större är chansen att du får det. Tänk på dig själv som en regissör som ger tydliga anvisningar till en skådespelare, eller en beställare som skriver en kravspecifikation till en leverantör.

Här är de fem nyckelkomponenter som nästan alltid förbättrar resultatet av en prompt:

1. Roll (Role): Vem ska AI:n vara? Genom att tilldela AI:n en specifik roll eller persona fokuserar du dess svar, tonläge och kunskapsbas. Det är skillnad på att be en "vänlig lärare" och en "kritisk akademiker" att förklara ett koncept.

- Exempel: "Agera som en vetenskapsjournalist..."

- Exempel: "Du är en pedagog som förklarar komplexa idéer för en tioåring..."

- Exempel: "Var en cynisk och kritisk granskare av följande text..."

2. Uppgift (Task): Vad exakt ska AI:n göra? Var extremt tydlig med ditt slutmål. Använd starka, aktiva verb. Ska den sammanfatta, analysera, jämföra, generera en lista, skriva om, översätta eller skapa en tabell? "Berätta om X" är en dålig uppgift. "Identifiera de tre starkaste argumenten och de tre svagaste argumenten i följande text" är en utmärkt uppgift.

- Exempel: "...och skriv en kort analys av de största möjligheterna och de mest allvarliga riskerna med gentekniken CRISPR-Cas9."

3. Kontext (Context): Vilken bakgrundsinformation behövs? Detta är kanske den viktigaste komponenten. En AI har ingen aning om din situation om du inte berättar den. Ge all nödvändig bakgrundsinformation. Klistra in den text du vill att den ska arbeta med, beskriv situationen, eller referera till tidigare delar av er konversation. Ju mer relevant kontext du ger, desto mer relevant blir svaret.

- Exempel: "Fokusera på konkreta exempel, som potentialen att bota ärftliga sjukdomar, men också på de etiska dilemman som tekniken väcker. Läs denna bifogade debattartikel och referera till den: ..."

4. Målgrupp (Audience): Vem är mottagaren? Vem ska läsa eller använda resultatet? Är det för dig själv? Din professor? En grupp nybörjare? Din mormor? Att definiera målgruppen styr språk, komplexitet och formalitetsnivå.

- Exempel: "Texten ska rikta sig till nyfikna gymnasieelever på naturvetenskapsprogrammet som har grundläggande kunskaper i biologi."

5. Format (Format): Hur ska resultatet se ut? Specificera exakt hur du vill att svaret ska struktureras. Utan anvisningar får du ofta en vägg av text. Be istället om en punktlista, en tabell med specifika kolumner, en essä med tre stycken, en dialog, eller kod i ett visst programmeringsspråk.

- Exempel: "Strukturera svaret med en kort inledning, följt av en punktlista för 'Möjligheter' och en punktlista för 'Risker'."

Från dåligt till bra: Ett exempel

Låt oss se hur dessa komponenter förvandlar en dålig prompt till en bra, med ett ämne som är mer relevant för dig.

Dålig prompt:

"Berätta om CRISPR."

Resultatet blir troligen en torr, encyklopedisk text som förklarar den tekniska mekanismen men missar hela poängen med varför det är en så omvälvande teknik.

Bra prompt (med alla komponenter):

[Roll] Agera som en vetenskapsjournalist som skriver för en tidskrift i stil med Forskning & Framsteg.

[Uppgift] Skriv en kort analys av de största möjligheterna och de mest allvarliga riskerna med gentekniken CRISPR-Cas9.

[Målgrupp] Texten ska rikta sig till nyfikna gymnasieelever på naturvetenskapsprogrammet som har grundläggande kunskaper i biologi men inte är experter på genteknik.

[Kontext] Fokusera på konkreta exempel, som potentialen att bota ärftliga sjukdomar (t.ex. sicklecellanemi), men också på de etiska dilemman som tekniken väcker, exempelvis risken för "designer babies". Här finns ett utdrag från en debattartikel som du bör referera till: ...

[Format] Strukturera svaret med en kort inledning som förklarar vad CRISPR är på ett enkelt sätt, följt av en punktlista för "Möjligheter" och en punktlista för "Risker". Avsluta med ett sammanfattande stycke som reflekterar över teknikens framtid.

Genom att systematiskt inkludera dessa komponenter i dina prompter går du från att vara en passiv passagerare till att bli en aktiv förare som styr AI:n mot exakt det mål du vill uppnå.

Om du vill ha hjälp att komma ihåg så blir det CRAFT på engelska (Context, Role, Audience, Format, Task )

Akademisk Integritet: Gränsen mellan Verktyg och Fusk

När du använder dessa kraftfulla verktyg i dina studier är det avgörande att du förstår och respekterar gränsen mellan legitimt stöd och fusk.

- Legitimt stöd (Augmentation): Att använda AI för att bolla idéer, förklara svåra koncept, förbättra ditt språk, hitta fel i din kod(du kommer få möjlighet att koda senare i boken) eller organisera dina tankar. Här använder du AI:n som en personlig handledare eller en smart skrivassistent för att förbättra ditt eget arbete.

- Fusk (Automation): Att be AI:n skriva en hel uppsats åt dig, att lämna in AI-genererad text som din egen, eller att låta den göra en uppgift som är menad att testa din egen kunskap och förmåga. Här låter du AI:n göra jobbet istället för dig.

En bra tumregel är: Kan du självsäkert och i detalj förklara och försvara varje ord och idé i den text du lämnar in? Om svaret är ja, har du troligen använt AI på ett ansvarsfullt sätt. Om svaret är nej, har du passerat gränsen till fusk.

Skolor och universitet utvecklar snabbt nya regler för AI-användning. Att använda AI för att generera text och lämna in den som din egen ses nästan undantagslöst som plagiat. Konsekvenserna kan vara allt från underkänt på kursen till avstängning. Sätt dig alltid in i de specifika regler som gäller för just din utbildning.

Del B: Varför du måste vara kritisk

En AI-modell, särskilt en stor språkmodell, är som en extremt avancerad statistisk papegoja. Den har inte "förståelse" eller "kunskap" i mänsklig mening. Istället har den tränats på en ofattbar mängd text och bilder från internet, och lärt sig att känna igen och återskapa mönster i denna data.

Detta innebär två saker:

- Modellens "världsbild" är en direkt spegling av den data den har tränats på.

- Kvaliteten och naturen på denna data är av absolut avgörande betydelse.

Det är här vi stöter på några av de största och mest problematiska aspekterna av modern AI, som vi bäst förstår genom våra återkommande perspektiv.

Det ekonomiska perspektivet: Övervakningskapitalism

Var kommer all denna data ifrån? Till stor del kommer den från oss. Varje sökning du gör, varje klick du gör, varje plats du besöker med din telefon, varje interaktion du har på sociala medier – allt detta samlas in, lagras och analyseras.

Forskaren Shoshana Zuboff har gett detta system ett namn: övervakningskapitalism. Hennes poäng är att de stora tech-företagens affärsmodell inte längre bara handlar om att sälja produkter eller annonsplatser. Den primära produkten är förutsägelser om ditt framtida beteende. Genom att samla in enorma mängder data om dig kan de bygga modeller som försöker förutsäga vad du kommer att köpa, vilka politiska åsikter du lutar åt och vilka videor du kommer att titta på härnäst. Dessa förutsägelser säljs sedan till annonsörer och andra som vill påverka ditt beteende.

Denna data, som samlas in för kommersiell övervakning, blir sedan det "bränsle" som används för att träna de AI-modeller vi använder. Våra digitala fotspår omvandlas till den statistiska grunden för AI:ns "kunskap".

"...är det du som är produkten." Detta gamla talesätt från internet-eran är mer relevant än någonsin. I övervakningskapitalismens tidsålder är det mer precist att säga: "Du är inte produkten, du är råmaterialet." Din data är den naturresurs som utvinns för att skapa förutsägelseprodukter.

Det sociologiska perspektivet: Automatisering av Ojämlikhet

Eftersom AI-modeller lär sig från data som samlats in från vår värld, kommer de oundvikligen att ärva och förstärka de fördomar och ojämlikheter som redan finns i samhället. Detta kallas AI-bias.

Ett klassiskt exempel är när Amazon försökte bygga en AI för att automatiskt sålla bland jobbansökningar. Eftersom företaget historiskt sett hade anställt fler män än kvinnor i tekniska roller, lärde sig AI-modellen att ansökningar som innehöll ord som "kvinnor" (t.ex. "kapten för damlaget i schack") skulle nedgraderas. Modellen lärde sig inte att hitta de bästa kandidaterna, utan att imitera de partiska anställningsbeslut som människor hade fattat tidigare.

Detta är ett enormt problem. När vi börjar använda AI för att fatta viktiga beslut om lån, anställningar, eller till och med vem som ska beviljas villkorlig frigivning från fängelse, riskerar vi att bygga in historiska orättvisor i ett tekniskt system som ger sken av att vara objektivt och neutralt.

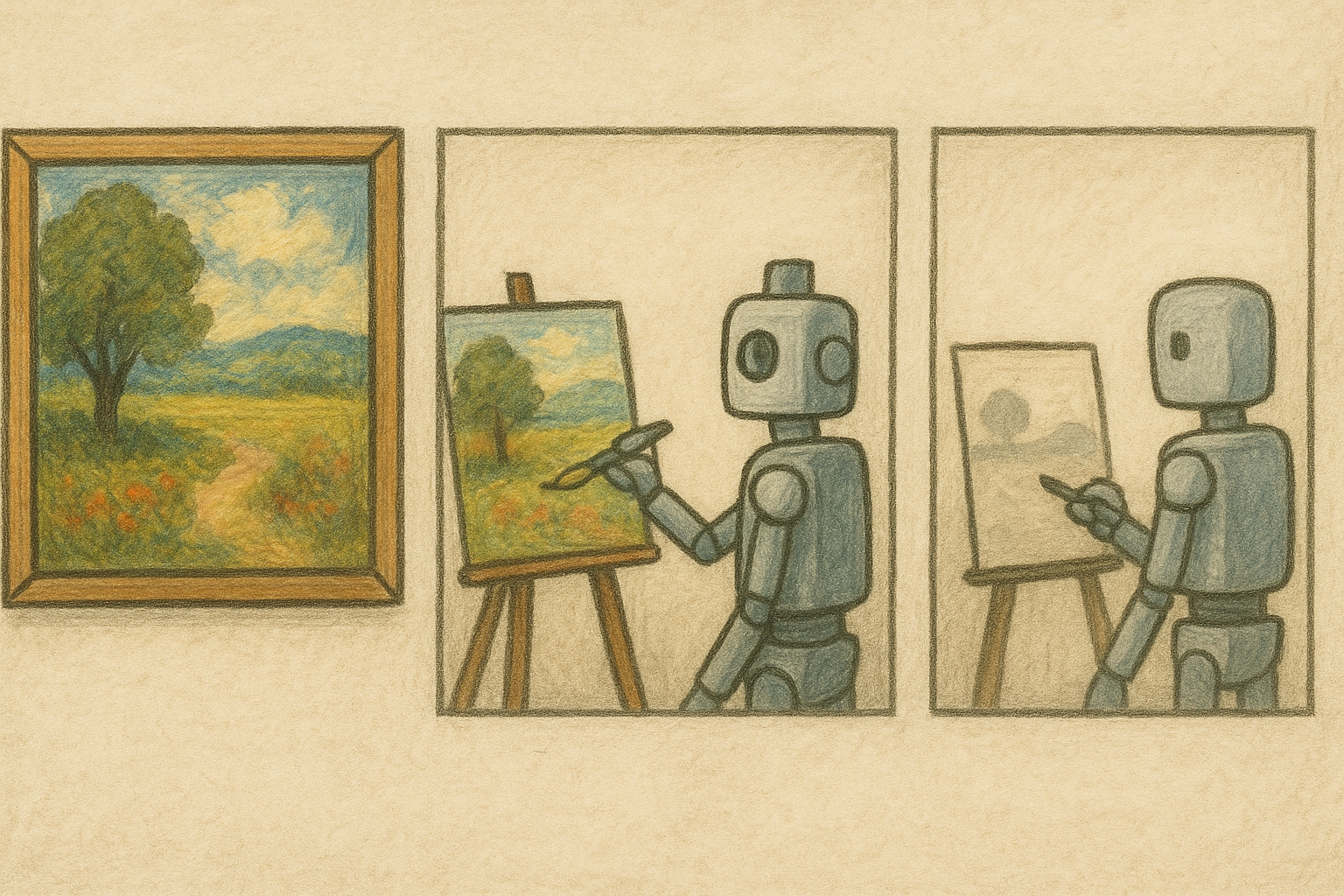

Det ekologiska perspektivet: Digital inavel och modellkollaps

Problemet med partisk och bristfällig träningsdata är inte bara ett historiskt problem. Det håller på att utvecklas till en akut framtidskris. Fram till nyligen har internet, trots sina brister, till största delen bestått av innehåll skapat av människor. Men nu fylls det i en exponentiell takt med text, bilder och kod som genererats av AI. Vad händer när nästa generation AI-modeller tränas på data som skapats av sina föregångare?

En studie publicerad i Nature 2024, "AI models collapse when trained on recursively generated data", ger ett alarmerande svar. Forskarna kallar fenomenet för modellkollaps (model collapse).

Processen är degenerativ och kan liknas vid att göra en fotokopia av en fotokopia(äldre läsare kommer ihåg kvalitén på bilder/text i uppgifter i skolan som skrivits ut och kopieras om och om igen). För varje generation förlorar modellen lite av detaljrikedomen och precisionen från den ursprungliga, mänskligt skapade datan. Mer specifikt börjar AI-modellerna glömma bort "uteliggarna" i datadistributionen – det vill säga de ovanliga, kreativa, avvikande och ibland geniala idéer som utgör mänsklighetens mångfald och innovationskraft. Med tiden konvergerar modellerna mot en alltmer förenklad, genomsnittlig och till slut förvrängd bild av verkligheten. De "misstolkar verkligheten", som forskarna uttrycker det.

Detta är en form av digital inavel. AI-systemen börjar mata sig själva med sin egen "skräpmat" av genomsnittligt och repetitivt innehåll, vilket leder till att de blir allt dummare och mindre kapabla över tid. Konsekvensen är dramatisk: värdet av äkta, verifierbar, mänskligt skapad data kommer att skjuta i höjden. Förmågan att skilja mellan mänskligt och syntetiskt innehåll blir inte bara en teknisk utmaning, utan en avgörande förutsättning för att AI-utvecklingen överhuvudtaget ska kunna fortsätta framåt.

Om internet blir alltmer fyllt med AI-genererat innehåll, som i sin tur tränar nya AI-modeller, var kommer ny, originell och mänsklig kunskap ifrån i framtiden? Hur säkerställer vi att vi inte fastnar i en digital ekokammare?

Det kognitiva & psykologiska perspektivet: Förstärkta fördomar och kognitiv skuld

Problemet med AI-bias och den urvattnade data som kan leda till modellkollaps förstärks av vår egen mänskliga psykologi, särskilt vår tendens till konfirmeringsbias (confirmation bias) – vi tenderar att omedvetet leta efter och favorisera information som bekräftar våra befintliga övertygelser. När en AI presenterar ett resultat som stämmer överens med vår magkänsla (som i sig kan vara färgad av fördomar), är vi mindre benägna att granska det kritiskt.

Utöver att förstärka våra fördomar, finns en mer personlig och subtil risk med att ständigt använda kraftfulla AI-verktyg: risken för kognitiv avlastning. Blir vi helt enkelt dummare av att använda AI?

Svaret är komplicerat. Forskning har länge visat på "Google-effekten": vi är sämre på att komma ihåg information som vi vet att vi enkelt kan hitta på nätet. Vi memorerar inte själva faktan, utan var vi kan hitta den. Med stora språkmodeller kan denna avlastning bli ännu djupare. Risken är inte bara att vi slutar memorera fakta, utan att vi avlastar själva processen att tänka. Att formulera en sammanhängande argumentation, att hitta de rätta orden för en komplex känsla, att strukturera en text – allt detta är kognitiva färdigheter som, likt muskler, behöver tränas.

En uppmärksammad studie från MIT, "Your Brain on ChatGPT: Accumulation of Cognitive Debt when Using an AI Assistant for Essay Writing Task", ger en obehaglig inblick i just detta. Forskarna lät deltagare skriva uppsatser i tre olika grupper: en som endast använde ChatGPT (LLM-gruppen), en som använde traditionella sökmotorer och en som bara fick använda sin egen hjärna ("brain-only"). Genom att mäta hjärnaktiviteten med EEG kunde de se exakt vad som hände kognitivt.

Resultaten är slående. Deltagarna i LLM-gruppen uppvisade den svagaste neurala aktiviteten och nätverkskopplingarna i hjärnan. Hjärnaktiviteten "skalade ner i proportion till mängden externt stöd", som forskarna uttryckte det. Det mest anmärkningsvärda var dock ett konkret beteendemässigt test: direkt efter att ha skrivit sina texter hade deltagarna i LLM-gruppen signifikant sämre förmåga att minnas och korrekt citera meningar från sina egna essäer. Informationen hade aldrig riktigt bearbetats eller lagrats i minnet; den kognitiva processen hade avlastats så till den grad att deltagarna inte kände "ägarskap" över texten. Forskarna kallar detta fenomen för ackumulering av "kognitiv skuld" (cognitive debt).

Denna tendens att lita för blint på tekniken kan få allvarliga konsekvenser, även för högpresterande proffs. I en berömd studie från Harvard Business School, med titeln "Navigating the Jagged Technological Frontier", lät man managementkonsulter från Boston Consulting Group (BCG) lösa komplexa affärsproblem. En grupp fick använda AI, den andra inte. För uppgifter som AI:n var bra på presterade AI-gruppen bättre. Men när de ställdes inför en uppgift som krävde mer kreativt och nyanserat tänkande – en uppgift AI:n var dålig på – presterade AI-gruppen signifikant sämre än gruppen utan AI. De föll offer för automationsbias – en mänsklig tendens att okritiskt föredra förslag från ett automatiserat system – och litade på AI:ns självsäkra men felaktiga svar istället för sitt eget omdöme.

En ytterligare anmärkningsvärd studie från forskningsorganisationen METR, "Measuring the Impact of Early-2025 AI on Experienced Open-Source Developer Productivity", visar att denna problematik kan leda till direkt försämrad prestation, även för experter inom AI:ns absoluta kärnområde: kodning. I ett experiment fick erfarna programmerare i uppdrag att lösa problem i kodbaser de redan kände till, antingen med eller utan de senaste AI-verktygen.

Resultatet var det motsatta mot vad alla förväntade sig: när de tilläts använda AI-verktyg tog uppgifterna i genomsnitt 19% längre tid. Istället för att koda ägnade de mer tid åt att skriva och justera prompter, vänta på svar och framför allt – granska, felsöka och korrigera den AI-genererade koden. För en expert blev AI-assistenten inte ett verktyg för acceleration, utan en tidskrävande mellanhand.

Tillsammans illustrerar dessa studier en perfekt storm av kognitiv avlastning och felkalibrerad tillit. Kanske mest talande var att programmerarna i METR-studien, även efteråt, fortfarande uppskattade att AI hade sparat dem tid, trots att mätningarna visade motsatsen. Deras tro på verktygets effektivitet var så stark att den överskuggade deras faktiska erfarenhet av att bli långsammare. Både Harvard-studien och METR-studien visar att en okritisk tillit till AI kan leda till sämre och långsammare resultat, särskilt när verktyget används utanför sitt expertområde eller när användaren själv är en expert.

Målet är därför inte att såga dessa verktyg, utan att utveckla ett förhållningssätt som en skicklig hantverkare. En snickare använder en elektrisk såg för att snabbt kapa brädor, men hon förlorar inte förmågan att använda en handsåg när precision och finkänslighet krävs. På samma sätt måste vi lära oss att använda AI för att accelerera vårt arbete, men medvetet fortsätta att öva på de grundläggande kognitiva färdigheterna som definierar ett klart och självständigt tänkande. Studierna från MIT, Harvard och METR är en stark varningssignal: om vi inte är medvetna om risken för kognitiv skuld och automationsbias, kan verktygen som är designade för att göra oss smartare i själva verket göra vårt arbete både sämre och långsammare.

Lag & Samhälle: Ett försök till kontroll

Som ett svar på dessa risker har lagstiftare runt om i världen börjat agera. De två viktigaste regelverken att känna till i Europa är:

- GDPR (General Data Protection Regulation): Denna lag, som infördes 2018, ger EU-medborgare större kontroll över sina personuppgifter. Den ger dig rätten att veta vilken data företag har om dig, rätten att få den raderad, och kräver att företag har ditt samtycke för att samla in den.

- EU AI Act: Detta är ett nyare och mer ambitiöst lagförslag som syftar till att reglera själva AI-systemen. Lagen delar in AI-tillämpningar i olika riskkategorier. System med "oacceptabel risk" (som sociala poängsystem) blir helt förbjudna. System med "hög risk" (som i rekrytering eller brottsbekämpning) måste uppfylla strikta krav på transparens, säkerhet och mänsklig översyn.

Dessa lagar är samhällets försök att hitta en balans – att kunna dra nytta av AI:s fördelar utan att offra grundläggande rättigheter och demokratiska värderingar.