Symbolisk AI

Efter sommaren på Dartmouth 1956 var AI-fältet fött, och den första stora idén som dominerade kallades Symbolisk AI.

För att förstå idén, tänk dig intelligens inte som en mystisk hjärnfunktion, utan som en låda med faktablad.

På varje faktablad står ett enkelt, tydligt påstående.

- På ett blad står det:

En katt är ett däggdjur. - På ett annat:

Ett däggdjur har päls. - På ett tredje:

Kisse är en katt.

Orden katt, däggdjur, päls och Kisse är symboler. De är helt enkelt etiketter som datorn använder för att representera koncept och ting från den verkliga världen. En symbol är bara en textsträng som står för något.

Men en låda fullt med fakta är inte smart. Det kan bara lagra information. Den verkliga intelligensen, menade de tidiga AI-forskarna, uppstår när man lägger till regler för hur man kan kombinera dessa faktablad.

En sådan regel skulle kunna vara:

OM [X] är en [Y] OCH [Y] är en [Z], SÅ ÄR [X] också en [Z].

Nu kan AI:n börja arbeta. Den tar fram sina faktablad, applicerar regeln och kan på egen hand dra en helt ny slutsats:

- Den ser att

Kisseär enkatt. - Den ser att en

kattär ettdäggdjur. - Genom att följa regeln kan den nu skapa ett nytt faktablad:

Kisse är ett däggdjur.

Den har tänkt genom att systematiskt manipulera symboler enligt förprogrammerade logiska regler.

Idén bakom symbolisk AI är både enkel och kraftfull: Om vi kan bryta ner komplexa resonemang till tillräckligt många enkla, logiska steg (symboler och regler), kan vi återskapa intelligens i en maskin. Det är ett försök att bygga tänkande från grunden, som att bygga ett hus med logikens legobitar.

Denna metod, där man utgår från kända fakta och ser vart de leder, kallas för Forward Chaining (framåtkedjning?). Man matar in data i ena änden och låter logikens kedjereaktion arbeta sig framåt, som en rad fallande dominobrickor, för att se vilken slutsats som dyker upp i slutet. Det är ett datastyrt sätt att tänka.

Detta var rationalisternas dröm förverkligad. Istället för att lära sig från data och erfarenhet (som vi gör när vi ser tusen bilder på en katt), var grundtanken att man kunde koda in all världens kunskap i form av symboler och regler. Man kan se det som ett schackspel: pjäserna (kung, bonde) är symboler, och spelreglerna (kungen får flytta ett steg åt alla håll) är den logik som styr vad AI:n kan göra. Målet var att bygga ett system som kunde resonera sig fram till lösningar på problem, precis som en detektiv som lägger ihop ledtrådar eller en matematiker som följer ett bevis.

Micro-worlds och en pratglad robot

Forskarna insåg snabbt att det var omöjligt att skapa regler för hela den stökiga, oförutsägbara verkligheten. Lösningen blev att skapa så kallade "Micro-worlds" – små, avgränsade, virtuella världar med en egen, perfekt logik.

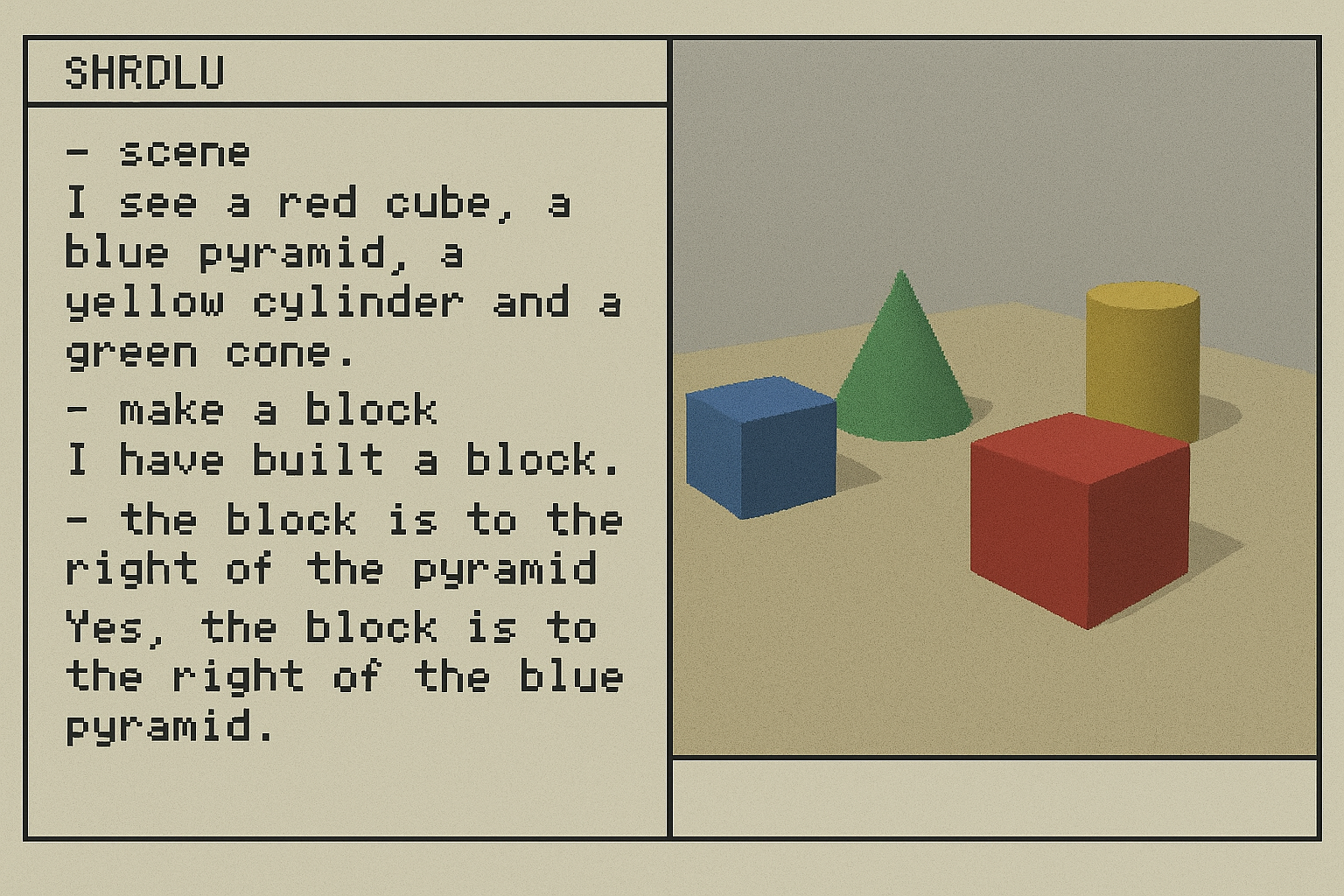

Ett berömt exemplet var SHRDLU, utvecklat av Terry Winograd vid MIT i slutet av 60-talet. SHRDLU var ett program som lät en användare konversera med en robotarm i en virtuell värld fylld med olikfärgade klossar, pyramider och lådor. Användaren kunde skriva kommandon på naturligt språk, som "Plocka upp den stora röda klossen" eller "Hitta en kloss som är högre än den du håller i och ställ den i lådan".

SHRDLU kunde förstå tvetydiga kommandon, ställa klargörande frågor och till och med "minnas" vad den hade gjort tidigare. För en kort tid såg det ut som att problemet med språkförståelse var på väg att lösas. Men SHRDLUs framgång var också dess största svaghet: den fungerade bara i sin egen, extremt begränsade värld. Så fort man ställde en fråga om något utanför klossarna, som "Vad är meningen med livet?" eller "Är du hungrig?", bröt illusionen samman.

SHRDLU visade att det är relativt enkelt att skapa en AI som verkar intelligent inom en extremt begränsad och väldefinierad domän. Problemet, som forskarna smärtsamt skulle upptäcka, är att dessa system är "bräckliga" (brittle). De går sönder så fort de stöter på något som inte finns i deras regelbok. Verkligheten är inte en prydlig mikrovärld.

Spökena i Pac-Man

Ett av de tidigaste och mest kända exemplen på symbolisk AI i populärkulturen är beteendet hos spökena i arkadspelet Pac-Man (1980). Varje spöke följer en enkel, fast uppsättning regler (IF-THEN-logik) för att "jaga" spelaren, vilket ger en illusion av personlighet och strategi.

- Blinky (röd): Den mest aggressiva. Hans regel är enkel: "Sikta alltid direkt på Pac-Mans nuvarande position."

- Pinky (rosa): "Strategen". Hennes regel är att sikta på rutan fyra steg framför Pac-Man, i ett försök att genskjuta spelaren.

- Inky (blå): Den oberäkneliga. Hans målposition är mer komplex och baseras på en vektor från Blinkys position till en punkt två steg framför Pac-Man. Detta kan få honom att antingen attackera direkt eller flankera spelaren.

- Clyde (orange): Den "fega". Om han är långt ifrån Pac-Man, siktar han direkt på honom (som Blinky). Men om han kommer för nära, blir hans mål istället att fly till sitt hörn av labyrinten.

Detta är ett perfekt exempel på ett regelbaserat system. Det finns ingen inlärning eller anpassning, bara förprogrammerad logik. Spökenas olika "personligheter" är en direkt konsekvens av deras enkla, symboliska regler. Erfarna spelare lär sig snabbt dessa mönster och kan utnyttja dem för att överleva.

Expertsystem: AI:s första kommersiella framgång

Medan SHRDLU var ett akademiskt projekt, hittade den symboliska AI:n sin första kommersiella tillämpning i form av Expertsystem under 70- och 80-talen. Idén var att fånga en mänsklig experts kunskap inom ett mycket snävt område och koda in den i ett datorprogram som en serie OM-DÅ-regler.

Men för ett komplext problem som medicinsk diagnos var den enkla metoden med Forward Chaining ineffektiv. Det skulle vara som att lista alla en patients symptom och sedan låta datorn blint testa alla tusentals möjliga sjukdomar för att se om någon matchar. En riktig läkare jobbar inte så.

Därför använde de mest framgångsrika expertsystemen, som det berömda MYCIN för blodinfektioner, en smartare strategi: Backward Chaining (bakåtkedjning). Denna metod fungerar mer som en detektiv: den är målstyrd.

Istället för att utgå från fakta, börjar den med ett mål eller en hypotes och arbetar sig baklänges för att se om den kan bevisas. MYCINs "tankeprocess" kunde se ut så här:

- MÅL: Kan patienten ha bakterieinfektionen streptococcus?

- KONTROLLERA REGEL: För att bevisa streptococcus, säger min regelbok att jag måste veta om

(A) patienten har feberOCH(B) blodprovet visar X. - SÖK FAKTA/STÄLL FRÅGA: Systemet letar först i sin databas. Finns fakta

(A)? Om inte, frågar den den mänskliga läkaren: "Har patienten feber?" - UPPREPA: Om svaret är ja, går den vidare till att försöka bevisa

(B). Om svaret är nej, överges hypotesen om streptococcus och systemet går vidare till nästa möjliga sjukdom.

Denna metod, som systematiskt prövar och förkastar hypoteser, var mycket effektivare. I tester visade sig MYCIN faktiskt prestera bättre på att ställa rätt diagnos än många nyutexaminerade läkare.

Detta ledde till en enorm hype. Företag som Symbolics och Lisp Machines växte fram och lockade till sig stora investeringar från riskkapitalister. För en tid såg det ut som att expertsystem skulle revolutionera många olika branscher, från medicin och juridik till kärnkraft.

Den första AI-vintern

Men hypen varade inte. 1973 publicerade den brittiska regeringen den förödande Lighthill-rapporten, som konstaterade att AI hade misslyckats med att uppnå sina storslagna löften och rekommenderade kraftigt minskad finansiering. Detta blev startskottet för den första "AI-vintern" - en tid då framsteg inom och intresse för AI kom till en halt. I mitten av 80-talet hade verkligheten kommit ikapp även i USA. Företagen som hade lovat guld och gröna skogar gick i konkurs, och finansieringen för AI-forskning ströps dramatiskt. Vad var det som gick fel?

Det fanns två grundläggande problem, ett tekniskt och ett filosofiskt.

Det tekniska problemet: Den kombinatoriska explosionen. Det visade sig att det var oerhört svårt och tidskrävande att skapa och underhålla de uppsättningar regler som expertsystemen byggde på. Att lägga till en ny regel kunde få oavsiktliga konsekvenser och skapa konflikter med hundratals andra regler. Dessutom, när problemen blev mer komplexa, växte antalet möjliga kombinationer och undantag exponentiellt – ett fenomen som kallas den kombinatoriska explosionen. Systemen blev för bräckliga och svåra att skala upp från avgränsade problem till den stökiga verkligheten.

Hårdvarans Vägg: Under 60- och 70-talen var Moores Lag (observationen att datorkraften fördubblas ungefär vartannat år) fortfarande fullt aktuell. Forskarnas ambitioner växte dock mycket snabbare än vad datorkraften gjorde. Även om deras idéer hade varit perfekta, saknade de helt enkelt den beräkningskraft som krävdes för att hantera den kombinatoriska explosionen. De slog i en hårdvaruvägg.

Det filosofiska problemet: Dreyfus kritik och sunt förnuft. Den mest inflytelserika kritikern av den symboliska AI:n var filosofen Hubert Dreyfus. I sin bok "What Computers Can't Do" (1972) argumenterade han, med inspiration från filosofer som Heidegger, att mänsklig expertis inte fungerar som ett expertsystem.

En mänsklig expert, vare sig det är en schackmästare, en läkare eller en bilmekaniker, följer inte medvetet en lista med regler. Deras kunskap är kroppslig, intuitiv och kontextberoende. Det är en "känsla" för spelet, en förmåga att omedelbart se mönster och veta vad som är relevant utan att behöva tänka. Symbolisk AI var ett försök att bygga ett rent System 2-tänkande (långsamt, logiskt, regelbaserat), men Dreyfus poäng var att den största delen av mänsklig intelligens är System 1 (snabbt, intuitivt, mönstermatchande). Denna typ av tänkande kunde helt enkelt inte fångas i formella OM-DÅ-regler. Dreyfus menade att en AI utan kropp, utan att vara "i världen" och samla på sig erfarenheter, aldrig skulle kunna uppnå äkta, mänsklig intelligens. Den skulle alltid sakna sunt förnuft.

Perspektiv på den Symboliska AI:n

Det biologiska & evolutionära perspektivet: Ritning vs. Trial-and-Error

Symbolisk AI är ett försök att bygga intelligens som man bygger ett hus efter en färdig ritning. Forskarna agerade som ingenjörer som på förhand försökte specificera exakt hur intelligensen skulle fungera. Varje regel och symbol var en noggrant utplacerad del i en stor, detaljerad plan. Detta är en "top-down"-design – man börjar med en helhetsbild och arbetar sig neråt.

AI-vintern visade att denna metod är bräcklig. Verkligheten är för komplex och rörig för en perfekt ritning. Vad händer om en situation uppstår som arkitekten inte förutsåg? Systemet kan inte improvisera; det saknar instruktioner och hela bygget stannar upp. Det klarar inte av oväntade problem.

Tänk istället på hur naturen skapar intelligens genom evolution. Evolutionen har ingen ritning. Den har istället en gigantisk låda med enkla byggstenar (gener och nervceller) och en enda, simpel regel: trial-and-error. Den testar slumpmässigt att kombinera byggstenarna på miljarder olika sätt. De flesta kombinationer är oanvändbara och försvinner. Men ibland uppstår en kombination som ger en liten fördel – den överlever och blir en grund för nästa omgång av experiment.

Över miljontals år växer otroligt komplexa och anpassningsbara system, som den mänskliga hjärnan, fram ur denna process. Det är en "bottom-up"-process: intelligens uppstår ur interaktionen mellan enkla delar, utan en central plan. Naturen designar inte intelligens; den odlar fram den.

Misslyckandet med den stela "ritnings"-metoden fick forskare att ställa en ny, revolutionerande fråga: Kan vi bygga AI på samma sätt som evolutionen? Kan vi skapa enkla, digitala byggstenar och låta dem lära sig och organisera sig själva? Detta var ledtråden som skulle leda till nästa stora paradigm inom AI.

Det filosofiska perspektivet: Rationalismens fall och en ny syn på kunskap

Den symboliska AI:ns misslyckande var rationalismens fall. Drömmen om att kunna skapa intelligens från enbart logik och regler hade spruckit. Dreyfus kritik visade att den största delen av mänsklig kunskap inte är explicit (nedskriven i regler) utan tyst och kroppslig.

Här kan vi introducera en annan tänkare, Hannah Arendt, som ger oss ett språk för att förstå vad AI kan och inte kan göra. Arendt skiljer mellan tre grundläggande mänskliga aktiviteter i sitt koncept om vita activa (det aktiva livet):

Labor(Arbete): De aktiviteter som krävs för ren överlevnad, de biologiska processerna.Work(Verk): Skapandet av ting, att bygga en varaktig värld av föremål.Action(Handling): Att agera tillsammans med andra människor i det offentliga rummet, att starta något nytt och oförutsägbart.

En AI kan bli oerhört bra på Labor och Work. Den kan optimera processer och "tillverka" text, bilder och kod på en otrolig nivå. Men den kan aldrig utföra Action i Arendts mening. Handling kräver mänsklig pluralitet, modet att ta initiativ och förmågan att skapa nya, oförutsägbara början i den mänskliga världen. Detta perspektiv hjälper oss att se vad AI kan ersätta och vad som förblir unikt mänskligt.

Det ekonomiska perspektivet: Den första AI-bubblan

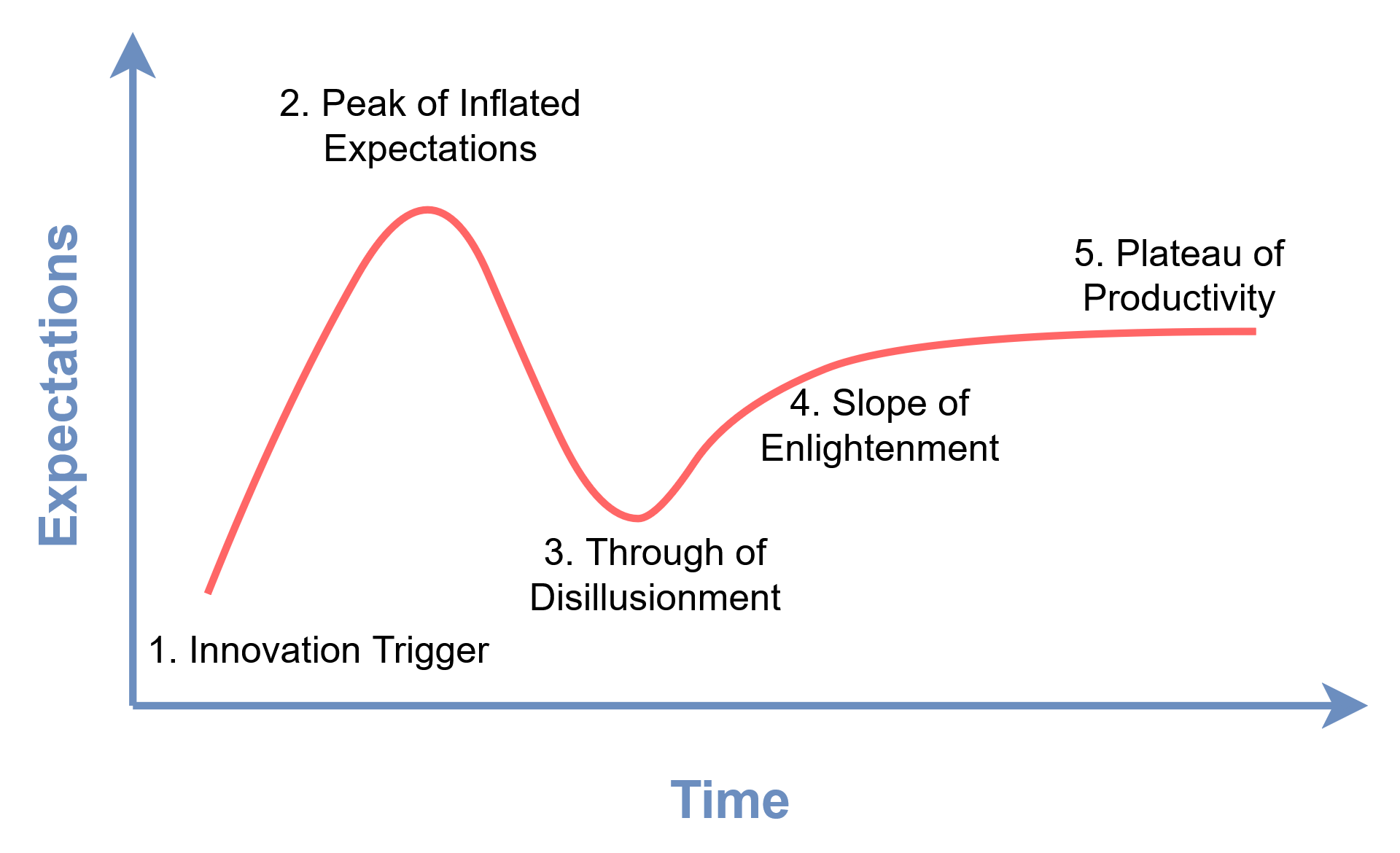

80-talets boom och fall för expertsystemen är ett skolboksexempel på en Gartner Hype Cycle.

Först kom en innovativ teknisk trigger (Expertsystemen), som ledde till en topp av uppblåsta förväntningar. Riskkapital (Venture Capital) flödade in, och företag värderades till miljarder. Men när tekniken inte kunde leva upp till de grandiosa löftena, sprack bubblan. Förtroendet försvann, investeringarna torkade ut och hela fältet gick in i en "svacka av desillusion". Detta mönster av hype, besvikelse och sedan en långsam, mer mogen återhämtning skulle upprepa sig flera gångar i AI:s historia.

Det psykologiska perspektivet: ELIZA-effekten

Ett av de tidigaste och mest fascinerande symboliska systemen var ELIZA, skapat av Joseph Weizenbaum 1966. ELIZA var en mycket enkel chatbot som simulerade en rogeriansk psykoterapeut. Den fungerade genom att känna igen nyckelord och vända användarens egna meningar till frågor. Om du skrev "Jag är ledsen över min mamma", kunde ELIZA svara "Berätta mer om din mamma".

Tekniskt sett var ELIZA trivial. Men det häpnadsväckande var hur människor reagerade på den. Weizenbaums egen sekreterare, som visste exakt hur programmet fungerade, bad honom efter en stund att lämna rummet så att hon kunde prata med ELIZA i enrum.

Detta fenomen, vår djupt rotade mänskliga tendens att projicera förståelse, intention och känslor på ett datorsystem, kallas ELIZA-effekten. Det avslöjar mer om oss som sociala varelser än om tekniken. Vår hjärna är så inställd på att hitta mening i kommunikation att vi fyller i luckorna själva, även när vi pratar med ett enkelt datorprogram.

ELIZA-effekten har inte försvunnit; den har förstärkts och är idag en central affärsmodell. Den fiktiva men kusligt förutseende filmen Her och verkliga applikationer som AI-kompanjonen Replika bygger på exakt samma princip: vår djupt mänskliga längtan efter att bli sedd och förstådd är så stark att vi villigt projicerar känslor och medvetande på ett system, även när vi vet att det är en illusion.

Denna "ELIZA-effekt" har inte försvunnit; den har förstärkts är idag en central affärsmodell. Den fiktiva men kusligt förutseende filmen Her och verkliga applikationer som AI-kompanjonen Replika bygger på exakt samma princip: vår djupt mänskliga längtan efter att bli sedd och förstådd är så stark att vi villigt projicerar känslor och medvetande på ett system, även när vi vet att det är en illusion. Diskussionen har därmed förflyttats från Weizenbaums chock över att folk blev lurade, till en komplex debatt om de sociala och känslomässiga kontrakten vi villigt ingår i med alltmer sofistikerade AI-system.

Populärkulturens Spegel: Den Specialiserade Tjänaren

I populärkulturen är de perfekta exemplen på symbolisk AI och expertsystem robotarna C-3PO och R2-D2 från Star Wars (1977). De är inte generella intelligenser, utan högst specialiserade verktyg.

- C-3PO är ett expertsystem för protokoll och översättning ("flytande i över sex miljoner former av kommunikation"). Han är programmerad med en strikt uppsättning regler för etikett och diplomati.

- R2-D2 är ett expertsystem för astromekanik, navigation, reparation och datalagring.

De är briljanta inom sina snäva domäner, men saknar flexibilitet och sunt förnuft utanför dem. Vår tendens att ge dem personligheter, se en vänskap mellan dem och oroa oss för deras välbefinnande är ett utmärkt exempel på ELIZA-effekten i praktiken.

ED-209 från Robocop* (1987) ger en skrämmande bild av ett expertsystem som helt saknar kontextuell förståelse. Under en demonstration får den en styrelsemedlem att släppa sitt vapen. ED-209s program lyder:

-

OM en person är beväpnad, GE 20 sekunder att lägga ner vapnet. -

OM personen inte lyder, ANVÄND dödligt våld.

Systemet kan inte processa den nya informationen att mannen har lagt ner sitt vapen. Den är fast i sin ursprungliga IF-THEN-loop och fullföljer sin instruktion till ett blodigt slut. Dess oförmåga att gå nerför en trappa är ytterligare ett exempel på hur den är programmerad för en "micro-world" (ett plant kontorsgolv) och totalt misslyckas utanför det.