Machine Learning

AI-vintern under det sena 80-talet och tidiga 90-talet var en tid av desillusion. Den symboliska AI:ns dröm, att bygga intelligens genom att förprogrammera logiska regler, hade kört fast i den kombinatoriska explosionens och det sunda förnuftets mur. Finansiering för forskning inom AI blev mindre och mindre.

Men under ytan, i skuggan av de misslyckade expertsystemen, pågick en tyst revolution. Istället för att försöka mata en maskin med färdiga regler (rationalism), vad skulle hända om man lät maskinen lära sig reglerna själv genom att titta på data (empirism)? Detta paradigmskifte, från att programmera kunskap till att träna den, markerade återkomsten för John Lockes "oskrivna tavla" och födelsen av det vi idag kallar Maskininlärning (Machine Learning, ML).

Connectionism: Hjärnan som Inspiration

Idén om att bygga en tänkande maskin genom att härma hjärnan var inte helt ny. Redan 1943 hade Warren McCulloch och Walter Pitts skapat en första matematisk modell av en biologisk neuron. De visade att denna enkla modell kunde fungera som en logisk grind (som AND, OR, NOT), de grundläggande byggstenarna i en dator. Detta lade grunden för fältet som kom att kallas connectionism – tanken att intelligens inte uppstår ur en enda komplex instruktion, utan ur de sammankopplade nätverken av många extremt enkla enheter, precis som i en hjärna.

Men för att förstå hur ett helt nätverk fungerar, måste vi först förstå dess minsta, men viktigaste, komponent.

Byggsten 1: Den Artificiella Neuronen (Beslutsfattaren)

Tänk dig en neuron som en extremt enkel beslutsfattare eller en grindvakt. Den gör tre saker, och vi kan visa det med ett konkret exempel.

Analogin: Ska jag gå på festen? Du funderar på om du ska gå på en fest. Dina inputs (informationen du baserar beslutet på) kan vara:

- Input A: "Är mina vänner där?"

- Input B: "Är det bra musik?"

- Input C: "Har jag ett prov imorgon?"

Låt oss nu omvandla detta till hur en artificiell neuron faktiskt "tänker" med siffror.

-

Den tar emot signaler (Input). Neuronen tar emot numeriska värden. Vi kan representera "Ja" som 1 och "Nej" som 0.

- Input A (vänner):

1(Ja) - Input B (musik):

0(Nej) - Input C (prov):

1(Ja)

- Input A (vänner):

-

Den väger signalerna (Weights). Alla signaler är inte lika viktiga. Vikten är en siffra som talar om hur mycket varje input ska påverka beslutet. En hög positiv vikt betyder "detta är mycket viktigt för ett JA". En hög negativ vikt betyder "detta är en stark anledning till ett NEJ".

- Vikt A (vänner):

+6(Superviktigt att vännerna är där!) - Vikt B (musik):

+2(Trevligt, men inte avgörande.) - Vikt C (prov):

-10(Ett prov är en deal-breaker!)

- Vikt A (vänner):

-

Den fattar ett beslut (Output). Neuronen gör nu en enkel uträkning: den multiplicerar varje input med dess vikt och summerar resultatet.

Beräkning = (Input A * Vikt A) + (Input B * Vikt B) + (Input C * Vikt C)Beräkning = (1 * 6) + (0 * 2) + (1 * -10)Beräkning = 6 + 0 - 10 = -4Slutligen jämförs denna summa med ett tröskelvärde (Threshold). Låt oss säga att tröskeln är

5. Om summan är över 5, "avfyrar" neuronen en signal (ett "Ja", eller en1). Annars gör den ingenting (ett "Nej", eller en0).Eftersom

-4är långt under tröskelvärdet5, blir outputen0. Beslutet är: "Nej, gå inte på festen."

Denna enkla mekanism – input, vikt, summa, tröskel, output – är den absoluta kärnan i nästan all modern AI. En enda neuron kan fatta ett enkelt beslut. Men den verkliga magin uppstår när vi ger den förmågan att lära sig.

Illustration: En enkel neuron.

Rita en cirkel (neuronen). Rita pilar som pekar in i cirkeln, märkta "Input A (1)", "Input B (0)", "Input C (1)". Skriv vikterna (t.ex. "+6", "+2", "-10") på pilarna. Inuti cirkeln, visa uträkningen (1*6)+(0*2)+(1*-10) = -4. Visa en pil som pekar ut från cirkeln, märkt "Output (0)", och en liten text vid sidan om: "Tröskelvärde: 5. Eftersom -4 < 5, blir output 0."

Byggsten 2: Perceptronen – Neuronen som Lär Sig

På 50-talet tog Frank Rosenblatt detta vidare och skapade Perceptronen. En Perceptron är i grunden en enskild neuron med en avgörande superkraft: förmågan att lära sig. Den gör detta genom att justera sina egna vikter baserat på sina misstag.

Föreställ dig en automatisk fruktsorteringsmaskin. Dess uppgift är att fatta ett enkelt, binärt beslut: Är äpplet "Säljbart" (t.ex. över 100 gram) eller ska det "Kasseras" (under 100 gram)?

Så här lär sig maskinen (Perceptronen):

- Input & Gissning: Maskinen "ser" ett nytt äpple med sina sensorer (input om t.ex. färg och uppskattad storlek). Baserat på sina nuvarande vikter gör den en gissning: "Säljbar!" (dess output är

1). - Facit: Äpplet rullar sedan vidare till en kontrollvåg som visar att det bara väger 95 gram. Det korrekta svaret var alltså "Kasseras" (det sanna värdet var

0). - Lärdom: Perceptronen gjorde fel! Den var för optimistisk. För att undvika samma misstag igen, justerar den sina interna vikter. Den kanske sänker vikten för "ser ganska stor ut" en aning, så att den blir lite mer försiktig nästa gång den ser ett liknande äpple.

Perceptronen lär sig alltså av sina misstag, ett litet steg i taget. Om den producerar ett felaktigt svar, justerar den sina interna vikter så att den är mer benägen att ge rätt svar nästa gång den ser en liknande input. Denna enkla inlärningsmekanism skapade en enorm optimism inom fältet.

Perceptronen justerar generellt sett sina vikter i en dedikerad "träningsfas", där facit finns tillgängliga, innan den får börja operera på nytt data där svaren inte är kända. Mer om detta i senare stycken!

Optimismen var enorm. Men den krossades 1969 när AI-pionjärerna Marvin Minsky och Seymour Papert publicerade boken "Perceptrons". I den bevisade de matematiskt att en enskild Perceptron hade en fundamental, inbyggd begränsning.

Problemet är att en enskild neuron bara kan lära sig att dra en enda rak linje för att separera data. Föreställ dig att du plottar in data på en 2D-graf. Neuronen kan lära sig att dra en linje och säga "allt på denna sida är Kategori A, och allt på den andra sidan är Kategori B".

Detta fungerar för enkla problem. Tänk dig att en neuron ska avgöra om en e-post är spam baserat på hur många gånger ordet "gratis" nämns och hur många utropstecken den innehåller. Om de flesta spam-mejlen har många av båda, kan neuronen enkelt lära sig att dra en diagonal linje som skiljer "spam" från "inte spam".

Men vad händer med mer komplexa problem?

Låt oss ta ett mer vardagligt problem: Att avgöra om en kopp kaffe är "perfekt". Dina två inputs (axlarna på grafen) är Temperatur och Sockerhalt.

Du vill inte ha kaffet för kallt, men inte heller skållhett. Du vill ha det sött, men inte sliskigt. Detta innebär att den "perfekta" koppen kaffe existerar inom ett litet, specifikt fönster – en "lagom"-zon i mitten av grafen.

Problemet är att de "dåliga" kopparna kaffe finns runtom den perfekta zonen:

- För kallt (längst ner på Temperatur-axeln)

- För hett (längst upp på Temperatur-axeln)

- För lite socker (längst till vänster på Socker-axeln)

- För mycket socker (längst till höger på Socker-axeln)

Försök nu att dra en enda rak linje som kan skilja alla de perfekta kopparna från alla de dåliga.

Det går inte! Oavsett hur du drar linjen kommer du alltid att antingen klumpa ihop bra kaffe med dåligt, eller exkludera en del av det bra kaffet. För att lösa detta problem skulle du behöva kunna rita en rektangel eller en cirkel runt den "perfekta" zonen. En enskild neuron kan inte göra det.

Minsky och Papert visade att detta "lagom"-problem hade en direkt matematisk motsvarighet i ett av de mest grundläggande logiska problemen: XOR ("antingen eller, men inte båda"). Låt oss bryta ner exakt vad det betyder och varför det var en katastrof för Perceptronen.

Vad är XOR? Tänk på en trappströmbrytare. Du har en lampa i en trappa med en strömbrytare både uppe och nere. Lampan ska tändas om en av strömbrytarna är på, men släckas om båda är på (eller om båda är av).

Detta är XOR-logik. Låt oss översätta det till siffror, där 1 är "PÅ" och 0 är "AV":

- Strömbrytare A är AV (

0) och B är AV (0) → Lampan är SLÄCKT (0). - Strömbrytare A är PÅ (

1) och B är AV (0) → Lampan är TÄND (1). - Strömbrytare A är AV (

0) och B är PÅ (1) → Lampan är TÄND (1). - Strömbrytare A är PÅ (

1) och B är PÅ (1) → Lampan är SLÄCKT (0).

XOR-problemet på en graf Nu gör vi exakt samma sak som med kaffet: vi plottar dessa fyra möjliga utfall på en 2D-graf. Strömbrytare A är x-axeln och Strömbrytare B är y-axeln. Vi använder en grön cirkel för "Lampa TÄND" och ett rött kryss for "Lampa SLÄCKT".

Du får då fyra punkter:

- En punkt vid (0, 0) som är ett rött kryss.

- En punkt vid (1, 0) som är en grön cirkel.

- En punkt vid (0, 1) som är en grön cirkel.

- En punkt vid (1, 1) som är ett rött kryss.

Den omöjliga linjen Precis som med kaffe-problemet är utmaningen nu: Kan en Perceptron dra en enda rak linje (tröskelvärdet) för att separera de gröna cirklarna från de röda kryssen?

Titta på grafen. Det är geometriskt omöjligt.

- En horisontell linje? Separerar inte.

- En vertikal linje? Separerar inte.

- En diagonal linje? Den kommer alltid att ha en grön cirkel och ett rött kryss på fel sida.

Detta var Minsky och Paperts dräpande bevis. De visade att eftersom en Perceptron bara kan lära sig linjära separationer, kunde den inte ens lösa ett av de mest grundläggande problemen inom logik och beräkning. Slutsatsen de drog var brutal: om denna modell inte ens klarar av en trappströmbrytare, hur ska den då någonsin kunna efterlikna den komplexa mänskliga hjärnan?

Kritiken var förödande. Den antydde att hela connectionism-spåret var en återvändsgränd och ströp finansieringen för nätverksforskning i nästan två decennier – den första "AI-vintern".

Illustration: XOR-problemet (den omöjliga linjen). Rita en 2D-graf med axlarna "Input A" och "Input B", där varje axel bara har punkterna 0 och 1.

- Rita ett rött kryss vid koordinaten (0, 0).

- Rita en grön cirkel vid koordinaten (1, 0).

- Rita en grön cirkel vid koordinaten (0, 1).

- Rita ett rött kryss vid koordinaten (1, 1).

- Rita en streckad linje för att visa ett misslyckat försök att separera cirklarna från kryssen. Skriv en bildtext: "Det är omöjligt att separera de gröna cirklarna från de röda kryssen med en enda rak linje."

Illustration: "Lagom"-problemet (eller det icke-linjära problemet). Rita en 2D-graf med axlarna "Temperatur" och "Sockerhalt". I mitten, rita en samling gröna punkter i en cirkulär eller rektangulär klunga, märkta "Perfekt kaffe". Runtomkring dem, sprid ut röda punkter, märkta "Dåligt kaffe". Visa sedan med ett par exempel (streckade linjer) att det är omöjligt att dra en enda rak linje som separerar alla de gröna punkterna från alla de röda.

Byggsten 3: Neurala Nätverk – Magin med Lager på Lager

Några få forskare vägrade ge upp. De insåg att problemet inte var neuronen i sig, utan att man bara använde en. Våra hjärnor har miljarder neuroner. Vad skulle hända om man, precis som i hjärnan, kopplade ihop massor av dem i lager? Detta skapar vad vi kallar ett Neuralt Nätverk.

Ett neuralt nätverk består vanligtvis av tre typer av lager:

- Input-lager: Tar emot den initiala datan. Varje neuron representerar en del av datan (t.ex. en pixel i en bild).

- Dolda lager (Hidden Layers): Ett eller flera mellanliggande lager. Här sker det verkliga "tänkandet". Magin ligger i att varje lager lär sig att känna igen mönster från det föregående lagret, vilket skapar en hierarki av kunskap.

- Output-lager: Producerar det slutgiltiga svaret (t.ex. "Detta är en bild på en katt").

Steg för steg: Hur ett nätverk lär sig känna igen siffran "4"

Låt oss följa datan genom ett enkelt nätverk som ska känna igen handskrivna siffror. Input är en liten bild, 28x28 pixlar, av siffran "4".

Steg 1: Input-lagret

Nätverket har 784 neuroner i sitt input-lager (28 * 28 = 784). Varje neuron tar emot värdet från en enda pixel – kanske 1 för en svart pixel och 0 för en vit. Detta lager "ser" bara en massa osammanhängande punkter.

Illustration: Input-lagret. Visa en bild av en handskriven "4" på ett rutnät. Rita sedan en kolumn av cirklar (neuroner) bredvid, och visa hur varje pixel mappas till en neuron i input-lagret.

Steg 2: Första Dolda Lagret – Hitta enkla former Neuronerna i detta lager får sina inputs från alla neuroner i input-lagret. Genom träning (som vi kommer till) har de specialiserat sig.

- Neuron A i detta lager kanske har lärt sig att "avfyra" starkt när den ser en kort, vertikal linje i det övre vänstra hörnet. Den har utvecklat höga positiva vikter för pixlarna i just det området och låga eller negativa vikter för alla andra.

- Neuron B har lärt sig att känna igen en horisontell linje i mitten.

- Neuron C har lärt sig att känna igen en lång, vertikal linje till höger.

När bilden av en "4" matas in, kommer Neuron A, B och C alla att avfyra starkt, medan en neuron som letar efter en cirkel (som i en "8" eller "0") kommer att vara tyst. Outputen från detta lager är alltså inte längre pixlar, utan en samling koncept: "ja, det finns en vertikal linje här", "ja, det finns en horisontell linje där".

Illustration: Första dolda lagret. Visa bilden av en "4". Rita sedan tre exempelneuroner från det dolda lagret. Från den första, rita linjer till pixlarna i den korta vertikala delen av "4:an" och färglägg dem. Gör likadant för de andra två neuronerna och deras respektive delar av siffran.

Steg 3: Andra Dolda Lagret (eller Output-lagret) – Kombinera formerna Neuronerna i detta lager får sina inputs från neuronerna i det föregående lagret. De lär sig att känna igen kombinationer av de enkla formerna.

- Det finns en neuron i output-lagret för varje möjlig siffra (0-9).

- "Fyra"-neuronen har lärt sig att den ska avfyra om den får starka signaler från de neuroner i föregående lager som känner igen "kort vertikal linje uppe till vänster", "horisontell linje i mitten" OCH "lång vertikal linje till höger". Den har alltså höga positiva vikter kopplade till just Neuron A, B och C.

- "Etta"-neuronen har istället lärt sig att den bara behöver en stark signal från Neuron C (lång vertikal linje).

Eftersom bilden av en "4" aktiverade A, B och C, kommer "Fyra"-neuronen att få en mycket hög summerad input och avfyra med högsta sannolikhet. Nätverkets svar blir: "Jag är 99% säker på att detta är en 4".

Träningen som gör detta möjligt: Backpropagation

Men hur vet nätverket vilka av dess miljontals vikter som ska justeras, och åt vilket håll? Detta är känt som "The Credit Assignment Problem" (ungefär "problemet med att fördela beröm och skuld"). Om nätverket gissar fel, vilka av de tusentals neuronerna och miljontals kopplingarna bär ansvaret?

Den geniala lösningen kom 1986 med en teknik kallad Backpropagation ("bakåtpropagering av fel").

Scenario: Nätverket gissar fel Vi matar in bilden av en "4", men nätverkets nuvarande vikter är dåliga, så den neuron som lyser starkast i output-lagret är "9"-neuronen. Den är 90% säker på att det är en nia. "4"-neuronen är bara 5% säker.

Felet är uppenbart. Nu börjar backpropagation-processen, som sker i två steg baklänges genom nätverket:

Steg 1: Skuldfördelning i sista lagret Algoritmen tittar på output-lagret och konstaterar:

- Till "9"-neuronen: "Du skulle ha varit tyst (

0), men du skrek högt (0.9). Ditt fel är stort och för högt. Du var för självsäker." - Till "4"-neuronen: "Du skulle ha skrikit högt (

1), men du viskade bara (0.05). Ditt fel är stort och för lågt. Du var för osäker." - Till de andra neuronerna (0, 1, 2, 3, 5, 6, 7, 8): "Ni var ganska tysta, vilket var rätt. Ert fel är litet."

Steg 2: En kedjereaktion av justeringar bakåt Nu börjar den verkliga magin. Varje felaktig neuron tittar "bakåt" på de kopplingar (vikter) och neuroner i det föregående lagret som gav den sin input.

-

"9"-neuronen resonerar så här: "Jag aktiverades för starkt. Vilka av mina inkommande signaler var starkast? Aha, det var från neuronerna i det dolda lagret som känner igen 'en cirkel högst upp' och 'en lång vertikal linje'. De bidrog mest till mitt misstag. För att jag ska göra mindre fel nästa gång, måste jag lita mindre på dem."

- Åtgärd: Algoritmen sänker vikten på kopplingen mellan "cirkel-neuronen" och "9"-neuronen. Den gör samma sak för "lång-vertikal-linje-neuronen".

-

"4"-neuronen resonerar samtidigt: "Jag aktiverades för svagt. Jag borde ha lyssnat mer på de neuroner som faktiskt signalerade korrekt. Aha, neuronerna för 'kort vertikal linje', 'horisontell linje' och 'lång vertikal linje' var alla aktiva. Deras bidrag var korrekt, men jag ignorerade dem."

- Åtgärd: Algoritmen höjer vikten på kopplingarna från dessa tre ingående neuronerna till "4"-neuronen.

Denna skuldfördelning fortsätter sedan bakåt. "Cirkel-neuronen" (som felaktigt bidrog till en "9:a") får nu själv en "skuldsignal" och resonerar: "Okej, jag aktiverades för starkt. Vilka pixlar i input-bilden var det som fick mig att aktiveras? Jag måste sänka vikterna från dem."

Många bäckar små

Varje enskild justering är pytteliten. Men processen upprepas för tusentals, ibland miljontals, exempelbilder. För varje bild gör nätverket en gissning, beräknar felet och skickar en våg av pyttesmå korrigeringar bakåt genom hela systemet.

Det är denna eleganta, matematiska process av att fördela skuld baklänges och göra små, ständiga justeringar som gör att ett nätverk kan gå från att gissa slumpmässigt till att klassificera bilder med övermänsklig precision. Plötsligt var vägen öppen för att bygga de djupt komplexa och kraftfulla inlärningssystem vi ser idag.

Illustration: Hela nätverket. En översiktsbild som visar:

- Input-lagret (en matris av neuroner som representerar "4:an").

- Pilar till Första Dolda Lagret, där några neuroner är upplysta (de som känner igen kanter/linjer i "4:an").

- Pilar till Output-lagret (10 neuroner, 0-9), där endast neuronen för "4" är starkt upplyst.

- En böjd pil märkt "Backpropagation" som går från output bakåt genom nätverket, för att visa hur felet justerar vikterna.

De Två Stora Familjerna av ML

Klassisk maskininlärning delas oftast in i två huvudkategorier, baserat på vilken typ av data man har och vad man vill uppnå.

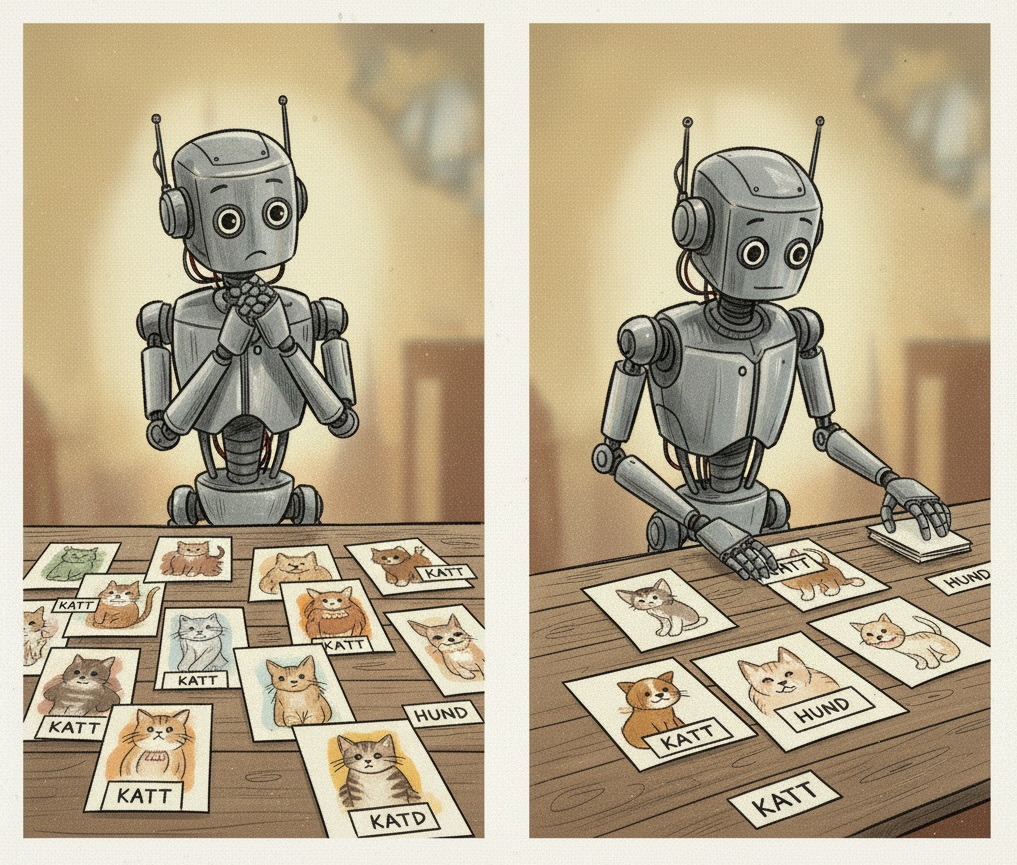

Supervised Learning (Övervakad Inlärning)

Detta är den vanligaste formen av maskininlärning. "Övervakad" betyder att vi tränar modellen på ett dataset där vi redan känner till de korrekta svaren. Vi har en "facitlista". Målet är att modellen ska lära sig den underliggande funktionen som kopplar ihop en input med en korrekt output, så att den sedan kan göra korrekta förutsägelser på ny, osedd data.

Inom övervakad inlärning finns två huvudtyper av problem:

-

Klassificering: Målet är att förutsäga en kategorisk etikett. Du sorterar data i fack.

- Exempel: Spam-filtrering. Modellen matas med tusentals e-postmeddelanden som manuellt har märkts som antingen "spam" eller "inte spam". Modellen lär sig att känna igen mönster (vissa ord, avsändare, länkar) som är typiska för skräppost. När ett nytt, okänt mejl kommer in, kan modellen klassificera det korrekt.

- Exempel: Bildigenkänning. Modellen tränas på miljontals bilder som är märkta med vad de föreställer ("katt", "hund", "bil"). Den lär sig känna igen visuella mönster av pixlar som utgör en katt, och kan sedan identifiera katter i helt nya bilder.

-

Regression: Målet är att förutsäga ett kontinuerligt, numeriskt värde.

- Exempel: Huspriser. Modellen matas med data om tusentals sålda hus, där varje hus har egenskaper (input: antal rum, yta, läge) och ett känt slutpris (output). Modellen lär sig hur dessa egenskaper viktas för att förutsäga priset på ett nytt hus som kommer ut på marknaden.

- Exempel: Försäljningsprognoser. Ett företag matar en modell med historisk försäljningsdata, information om väder, helgdagar och reklamkampanjer. Modellen lär sig sambanden och kan sedan förutsäga hur mycket glass de kommer att sälja nästa vecka.

En fundamental princip inom övervakad inlärning är uppdelningen i tränings- och testdata. Man tränar alltid modellen på en del av datan (t.ex. 80%) och utvärderar sedan dess prestanda på en separat, "osedd" del (de återstående 20%). Att testa på samma data som man tränat på vore som att ge en student exakt samma frågor på provet som de haft på sina övningsuppgifter – det mäter bara förmågan att memorera, inte att generalisera och faktiskt "kunna" ämnet.

Målet med all maskininlärning är generalisering, inte memorering. En bra modell är inte en som kan rabbla upp exakta svar från träningsdatan, utan en som har lärt sig de underliggande mönstren så väl att den kan göra korrekta förutsägelser på helt ny och osedd data.

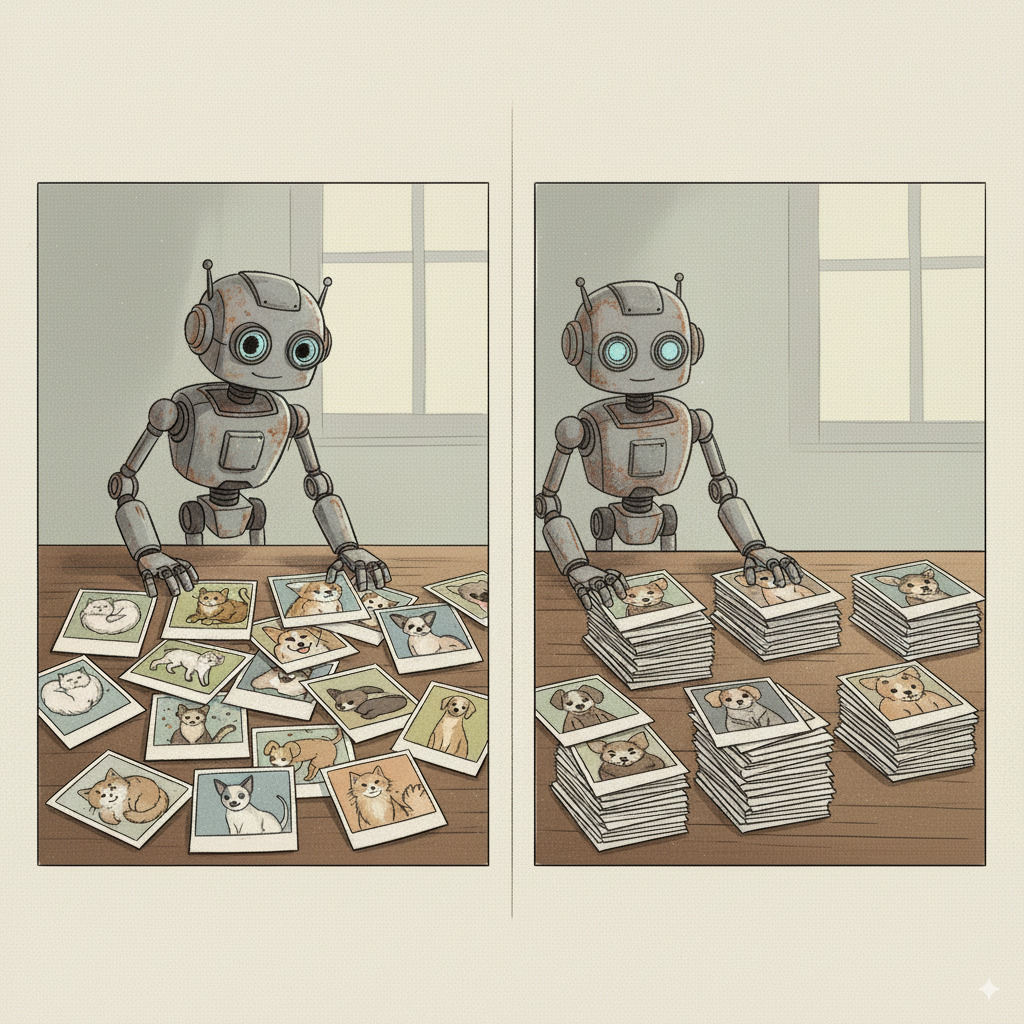

Unsupervised Learning (Oövervakad Inlärning)

Här har vi den motsatta och ofta mer utmanande situationen. Vi har ett dataset, men vi har ingen aning om vad de "korrekta" svaren är. Vi har ingen facitlista eller fördefinierade etiketter. Målet är istället att låta modellen agera som en digital upptäcktsresande och på egen hand hitta dolda mönster, strukturer och samband i datan. Det handlar inte om att förutsäga ett känt svar, utan om att skapa förståelse ur kaos.

De två vanligaste uppgifterna inom oövervakad inlärning är clustering och dimensionsreducering, och båda löser fundamentala problem när man arbetar med stora datamängder.

1. Clustering (Klustring)

Clustering-algoritmer har som mål att hitta den dolda, naturliga grupperingen i datan. Modellen försöker placera datapunkter som liknar varandra i "kluster" och samtidigt se till att klustren är så olika varandra som möjligt.

- Exempel: Kundsegmentering. En butikskedja matar in anonymiserad köpdata från tusentals kunder (vad de köper, när de handlar, hur mycket de spenderar). Clustering-algoritmen kanske på egen hand identifierar tre distinkta grupper: "studenter som handlar billigt på kvällar", "barnfamiljer som storhandlar på helger" och "pensionärer som köper specifika varor på förmiddagar".

Varför är detta viktigt? Att bara ha en stor mängd kunddata är inte särskilt användbart. Clustering omvandlar denna rådata till värdefull insikt.

- Målinriktad marknadsföring: Istället för att skicka samma reklam till alla, kan företaget nu skicka specifika erbjudanden som är relevanta för varje grupp. Detta ökar försäljningen och kundnöjdheten.

- Upptäcka nya marknader: Kanske hittar algoritmen ett oväntat kluster, t.ex. "personer som bara köper ekologiska produkter sent på tisdagar". Detta kan vara en helt ny nisch att utforska.

- Anomalidetektering: Om en ny datapunkt inte passar in i något av de befintliga klustren kan det vara en avvikelse, t.ex. ett bedrägligt köpbeteende eller ett fel i systemet.

2. Dimensionality Reduction (Dimensionsreducering)

Modern data innehåller ofta hundratals eller tusentals variabler (dimensioner) för varje datapunkt. Tänk dig en patientjournal med data om allt från blodtryck och vikt till hundratals olika genuttryck. Detta skapar två stora problem: det blir omöjligt för en människa att visualisera, och det kan göra maskininlärningsmodeller extremt långsamma och ineffektiva (ett fenomen som kallas "The Curse of Dimensionality").

Dimensionsreducering är en samling tekniker för att på ett intelligent sätt "komprimera" datan. Målet är att koka ner de hundratals variablerna till ett fåtal nya, super-variabler som fortfarande behåller den viktigaste informationen. Det är som att skriva en sammanfattning av en bok – du behåller kärnan i handlingen men tar bort onödiga detaljer.

Varför är detta viktigt? Detta är inte bara en teoretisk städövning, utan en kritisk process för att göra maskininlärning praktiskt genomförbar.

- Snabbare träning: En modell som tränar på 10 "super-variabler" istället för 1000 originalvariabler kan bli klar på minuter istället för dagar, vilket sparar enorma mängder tid och beräkningskraft.

- Minskat brus: Många av de ursprungliga variablerna kan vara redundanta (t.ex. ha både längd i meter och i fot) eller bara vara "brus". Dimensionsreducering hjälper till att filtrera bort detta och fokusera på den verkliga underliggande signalen, vilket ofta leder till mer träffsäkra modeller.

- Visualisering: Genom att reducera dimensionerna till 2 eller 3 kan vi faktiskt plotta datan i en graf och visuellt inspektera den. Detta är ett oerhört kraftfullt verktyg för att förstå datans struktur och se om det finns tydliga kluster innan man ens börjar träna en mer komplex modell.

Svenska Case: AI som Kassako

Under 2000-talet, när datorkraften och mängden tillgänglig data exploderade, blev maskininlärning ryggraden i många av de mest framgångsrika tech-bolagen.

-

Klarna: Hela Klarnas affärsmodell bygger på att snabbt kunna fatta ett kreditbeslut. När du klickar på "Köp nu, betala senare" måste de på en bråkdels sekund avgöra hur troligt det är att du faktiskt kommer att betala. Detta görs med en regressionsmodell som tar hundratals variabler (din köphistorik, tid på dygnet, typ av produkt, etc.) och producerar en "riskpoäng". Detta är klassisk maskininlärning i ett nötskal, där AI inte bara är en teknisk finess, utan en direkt förutsättning för hela affären.

-

Spotify: Hur kan Spotify upplevas som att den "känner" din musiksmak? Deras rekommendationsmotorer är ett sofistikerat exempel på hur flera ML-tekniker samverkar.

- Kollaborativ filtrering (Unsupervised): Systemet använder clustering för att hitta andra användare vars musiksmak liknar din. Den tittar sedan på vilka låtar de lyssnar på, som du ännu inte har upptäckt, och rekommenderar dem till dig. Den antar att om personer med liknande historisk smak gillar en viss låt, är chansen stor att du också kommer att göra det.

- Content-Based Filtering (Supervised): Spotify analyserar även ljudfilerna direkt för att extrahera hundratals musikaliska egenskaper (tempo, akustiskhet, "dansbarhet", tonart etc.). När du lyssnar mycket på en viss typ av låt, tränas en klassificeringsmodell att förstå din "smakprofil". Den kan sedan hitta helt nya låtar från okända artister som har liknande musikaliska egenskaper och rekommendera dem till dig.

Fallstudie: NPC:ns Hjärna – Beslutsträd i Spel

Innan mer avancerade inlärningsmetoder blev vanliga, tog spelutvecklare ett mellansteg från de enkla OM-DÅ-reglerna i Pac-Man. De började använda Beslutsträd, en klassisk modell inom maskininlärning, för att skapa mer komplext beteende hos sina datorstyrda karaktärer (NPCs).

Ett beslutsträd är precis vad det låter som: ett träd av frågor och beslut. Vid varje "nod" i trädet ställs en fråga om spelvärlden. Beroende på svaret följer NPC:n en "gren" till nästa fråga, och så vidare, tills den når ett "löv" som talar om för den vad den ska göra.

Ett enkelt, visuellt beslutsträd för en vakt i ett spel. Rotnod: "Ser jag spelaren?". Gren 1 (Ja): Leder till noden "Är spelaren nära?". Gren 1a (Ja): Leder till lövet "Attackera!". Gren 1b (Nej): Leder till lövet "Skjut på avstånd!". Gren 2 (Nej): Leder till noden "Hörde jag ett ljud?". Gren 2a (Ja): Leder till lövet "Gå och undersök!". Gren 2b (Nej): Leder till lövet "Fortsätt patrullera.".

Detta är fortfarande ett regelbaserat system, men det är mer organiserat och kan skapa ett mer nyanserat och trovärdigt beteende än en lång, rörig lista av IF-THEN-satser. Dess begränsning är dock att det är "handgjort". Varje regel och varje beslut måste designas och skrivas av en människa. Trädet kan inte lära sig av sina misstag eller anpassa sig till nya spelarstrategier. Det är ett statiskt system som, när det väl är knäckt av spelarna, förblir förutsägbart.

Verifiera dessa studier med tech-bloggarna som beskriver användningen.

Perspektiv på Klassisk Maskininlärning

Det filosofiska perspektivet: Empirismens Återkomst

Maskininlärning representerar en seger för empirismen. AI-forskare slutade försöka förprogrammera "sanningen". Istället skapade de system som kunde lära sig från erfarenhet (data). En ML-modell är en modern "Tabula Rasa", en oskriven tavla som fylls med kunskap genom observation av världen. Detta skifte från logik till statistik är det enskilt viktigaste som hänt i AI:s historia.

Det ekonomiska perspektivet: Från Akademisk Teori till Affärskritisk Motor

Den kanske största anledningen till att maskininlärning exploderade var att den skapade ett enormt och mätbart ekonomiskt värde. För första gången kunde företag gå från att reagera på vad deras kunder hade gjort, till att med hög precision förutsäga vad de skulle komma att göra. Amazons rekommendationsmotor, som föreslår produkter baserat på vad liknande kunder har köpt, är ett klassiskt exempel. Denna funktion, driven av maskininlärning, sägs stå för över en tredjedel av deras totala försäljning. ML var inte längre en akademisk leksak; det var en affärskritisk motor som kunde omvandla data till miljarder.

Det sociologiska perspektivet: Filterbubblor och Polarisering

När företag som YouTube och Facebook (numera Meta) började använda maskininlärning för att personalisera sina flöden, uppstod en oavsiktlig men kraftfull bieffekt. Genom att ständigt visa oss innehåll som liknar det vi redan gillat, skapade algoritmerna det som aktivisten Eli Pariser kallade filterbubblor.

Algoritmerna har inget ont uppsåt. Deras enda mål är att maximera din tid på plattformen. Men genom att optimera för engagemang, råkar de oavsiktligt gynna innehåll som är chockerande, upprörande eller extremt. Detta är en oavsiktlig konsekvens av ett system som är designat för att fånga din uppmärksamhet, inte för att ge dig en balanserad bild av världen.

Ditt personliga informationsuniversum skulpteras av algoritmer för att passa just dina preferenser. Problemet är att du inte ser vad som filtreras bort. Detta förstärks av algoritmisk amplifiering: innehåll som väcker starka känslor (ilska, rädsla, glädje) genererar mer engagemang (klick, kommentarer, delningar) och blir därför automatiskt prioriterat av systemet. Resultatet är att mer extrema eller polariserande budskap ofta får större spridning. Över tid kan detta leda till att vi hamnar i eko-kammare, där våra egna åsikter ständigt upprepas och förstärks, och vi får en förvrängd bild av hur "den andra sidan" tänker. Detta har pekats ut som en starkt bidragande orsak till den ökande politiska polariseringen i många länder. Detta går även att utnyttja för att uppnå specifika ändamål. Det mest ökända exemplet är Cambridge Analytica-skandalen, där ML-driven mikrotargeting användes för att försöka påverka valutgången i USA 2016.

Mikrotargeting är användningen av onlinedata för att skräddarsy reklambudskap till individer, baserat på identifiering av mottagarnas personliga sårbarheter.

Det kognitiva & psykologiska perspektivet: Uppmärksamhetsekonomin och den Algoritmiska Blicken

Varför är dessa personaliserade flöden så beroendeframkallande? Svaret ligger i hur de är designade för att utnyttja vårt belöningssystem. I en värld av informationsöverflöd är den verkliga bristvaran mänsklig uppmärksamhet. Hela affärsmodellen för många sociala medier bygger på att fånga och behålla din uppmärksamhet så länge som möjligt, för att kunna visa dig så många annonser som möjligt.

För att göra detta använder de en psykologisk mekanism som kallas intermittent förstärkning. Det är samma princip som gör spelautomater så beroendeframkallande. Du vet aldrig när nästa belöning (en rolig video, en intressant nyhet, en like på din bild) kommer att dyka upp. Denna oförutsägbarhet gör att din hjärna fortsätter att utsöndra dopamin, vilket får dig att fortsätta skrolla.

Över tid kan detta leda till att vi utvecklar en "algoritmiskt synsätt", där vi omedvetet börjar anpassa vårt eget beteende för att maximera den belöning vi får från plattformen. Vi börjar posta bilder, skriva inlägg eller skapa videor som vi tror att algoritmen kommer att gilla, snarare än vad som är mest autentiskt för oss själva. Vi börjar se på vår egen verklighet genom linsen av "kommer detta att fungera online?". Tänk på detta om ni någonsin tycker att influencer livsstilen känns lockande.